Dans notre ère technologique où la création d’aujourd’hui avance plus vite que celle de la veille, l’intelligence artificielle (IA) s’est insinuée dans le tissu de notre quotidien avec une subtilité déconcertante et surtout une rapidité qui interpelle. De la simplification de tâches répétitives à la prise de décisions complexes, l’IA promet un avenir où la machine et l’homme coexistent dans une harmonie productive. On a le droit de ne pas y croire. Aussi, cette promesse s’accompagne d’une question éthique brûlante : en cas d’erreur de l’IA, qui porte la responsabilité ?

La problématique de la responsabilité

L’IA, par sa capacité à apprendre et à évoluer, présente un défi unique en termes de responsabilité. Contrairement aux outils traditionnels, dont les erreurs peuvent souvent être attribuées à un défaut de fabrication ou à une mauvaise utilisation, l’IA ajoute une couche de complexité : elle peut se « tromper » en prenant des décisions basées sur son apprentissage. L’être humain apprend, tous les jours et à tout age. Ainis on a tous été débutant, on a tous eu nos premières fois, et à tout age. Aussi, il est très souvent pardonné à un être humain qui fait une erreur pour sa première fois. Pour l’ia, cela soulève d’autres questions, certaines éthiques, surtout lorsqu’il s’agit de systèmes autonomes qui prennent des décisions critiques, comme dans le domaine de la santé ou de la conduite automobile.

Études de cas : les leçons apprises

Plongeons dans le cas de systèmes de reconnaissance faciale, une technologie d’IA répandue. Des études ont montré que certains de ces systèmes ont plus de difficultés à identifier correctement des visages non blancs, ce qui a mené à des accusations injustifiées et à des erreurs judiciaires. Dans ce contexte, qui est responsable ? Le développeur du logiciel ? L’entreprise qui l’utilise ? Ou l’algorithme lui-même ?

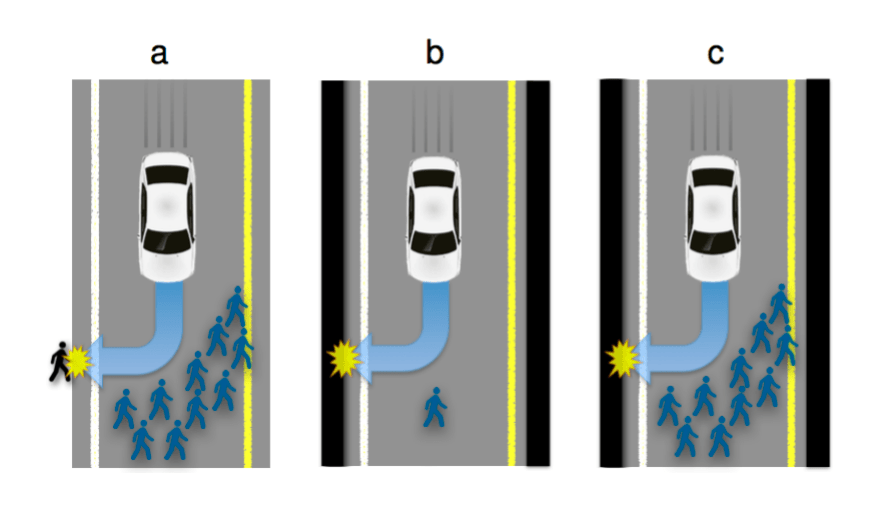

Un autre exemple frappant est celui des voitures autonomes. En cas d’accident causé par une défaillance de l’IA, la question de la responsabilité devient labyrinthique. Est-ce le fabricant de la voiture, le développeur de l’algorithme, ou le conducteur qui a fait confiance à la technologie qui doit être tenu responsable ? Cette question précise n’est d’ailleurs pas nouvelle. Ainsi en 2015 (il y a donc une éternité), le Massachusetts Institute of Technology (MIT) avait rédigé un article (en anglais) au sujet des voitures autonomes, en expliquant qu’elles sont programmées pour… tuer, y compris parfois leur conducteur. Les constructeurs ont choisi leur camp, puisque celui qui a déja conduit une Tesla, sait à quel point le paramétrage de la conduite autonome est ponctué de messages de mise en garde et autres avertissements de limitation de la responsabilité de la part de Tesla.

Implications pour les individus que nous sommes

Pour les TPE et les particuliers, ces questions ne sont pas que théoriques. Elles ont des implications directes sur la manière dont ils adoptent et intègrent l’IA dans leurs activités. L’assurance, la confiance des clients, et même la viabilité à long terme de leurs entreprises peuvent être affectées par la manière dont ces questions de responsabilité sont abordées.

Vers une solution collective

La responsabilité en cas d’erreur de l’IA ne peut être une charge portée par une seule entité. Elle requiert une collaboration entre développeurs d’IA, utilisateurs, législateurs et la société dans son ensemble. Des cadres réglementaires clairs, une éducation sur l’IA pour les utilisateurs, et un engagement envers des pratiques de développement éthique sont essentiels pour naviguer dans ce nouveau paysage technologique.

L’IA n’est pas seulement un outil technologique ; c’est un miroir reflétant nos valeurs, nos espoirs et nos craintes. En abordant les questions éthiques qu’elle soulève, notamment celle de la responsabilité, nous pouvons assurer que l’IA sert l’humanité de manière juste et équitable. Comme le souligne notre exploration de ChatGPT et d’autres outils, l’intelligence artificielle évolue et s’améliore, mais c’est probablement à nous, la société, de guider cette évolution de manière consciente et réfléchie.

Cet article a été rédigé grace à l’intelligence artificielle et a été édité et enrichi par un rédacteur humain